모두를 위한 머신러닝/딥러닝 강의: hunkim.github.io/ml/

Linear Regression (선형 회귀)

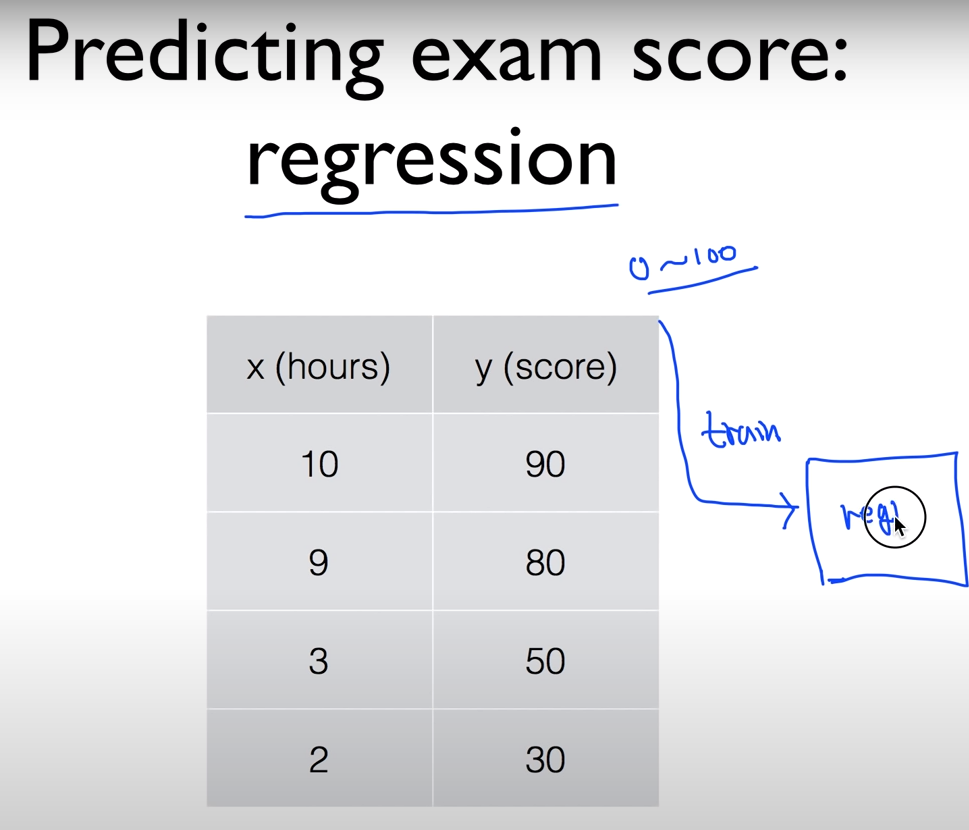

supervised learning를 한다고 하면 0~100에서의 데이터를 예측하는 경우 regression이라고 했는데

그렇다면 해당 데이터는 supervised learning를 위해 regression algorithm을 위한 trainning set이 되는 것이다.

해당 training set로 학습을 시키면 model이 생성되고 원하는 x를 넣어 prediction y를 구할 수 있게 되는 것이다.

그럼 이 tainning set이 존재하면 그 데이터들간의 Linear한 특징을 갖을 거라 가정하고 예측하는 기법이 Linear regression이다.

이렇게 일차함수 형식의 Linear한 직선들 중에서 가상 데이터의 표현이 가장 근접한 직선을 찾는 과정이 필요하다.

표시된 점(데이터)와의 거리가 짧은 것이 가장 좋은 hypothesis(가설)이다.

이제 그것을 계산할텐데, Linear regression에서는 Cost(Loss) function이라고 한다.

이렇게 실제 그었던 hypothesis와 실제 데이터간의 차이를 계산하는 것이다.

Cost Function : (H(x)-y)^2 의 값들의 평균

거리의 경우 음수가 나올 수도 있고, 이 거리가 커졌을 때 패널티를 크게 부여하기 위해 해당 차이의 제곱으로 Cost를 계산한다. (m은 데이터의 갯수이다.)

다음의 관계를 보면 결국 cost는 W와 b의 function이다. 나머지 값들은 정해져 있으나 해당 값들은 조절이 가능하고 결국 hypothesis을 어떻게 설정할 것인가를 결정하는 요소이다.

그리고 이 cost의 값이 가장 작은 값을 구하는 것이 목적인 것이다.

자!! 오늘도 감코!!

'ETC > 머신러닝, 딥러닝 실습' 카테고리의 다른 글

| 2-5. Linear Regression cost함수 최소화 개념 (0) | 2020.10.29 |

|---|---|

| 2-4. Linear Regression by Tensorflow (선형회귀 구현) (0) | 2020.10.28 |

| 2-2. Hello TensorFlow (basic tensorflow) (2) | 2020.10.28 |

| 2-1. Anaconda, Jupyter Notebook, tensorflow?? (0) | 2020.10.27 |

| 1-2. 머신러닝의 개념과 용어 (0) | 2020.10.10 |